IA Local vs IA en la Nube: privacidad, potencia y límites reales

Al hablar sobre IA local vs IA en la nube, hay dos pensamientos que se repiten demasiado:

“La IA local es solo para frikis y para empresas.”

“La nube es segura, tú cuéntale cualquier cosa.”

Los dos son erróneos.

La IA en la nube, con modelos como GPT-5.1, las versiones modernas de Claude, Gemini o los sistemas de vídeo estilo Grok, está haciendo cosas espectaculares: razonamiento muy profundo, código complejo, contextos gigantes, análisis multimodal avanzado, vídeo generativo coherente…

Pero al mismo tiempo, la IA local ha evolucionado brutalmente gracias a modelos open-weight como Llama, Qwen3, Gemma 2, DeepSeek V3, GPT-OSS y compañía. Todos ellos permiten tener potencia real en tu propio equipo con distintos niveles de exigencia.

La foto actual es esta:

- La nube sigue ganando en potencia máxima.

- La IA local gana en privacidad, control y autonomía, y cubre muchísimo más terreno del que la gente imagina.

Vamos al grano: qué hace cada enfoque, qué no hace, y qué GPU necesitas para aprovechar la IA local de verdad.

Qué es IA en la Nube y qué es IA Local

IA en la Nube

Tu prompt viaja a servidores externos donde viven modelos gigantescos.

Ventajas:

- Acceso inmediato a modelos del estilo GPT-5.1 Pro/Thinking, inalcanzables para cualquier GPU doméstica.

- Herramientas integradas: browsing, análisis web, visión, audio, asistentes complejos.

- Cero instalación.

Desventajas:

- Tus datos salen de tu máquina.

- Dependencia total del proveedor.

- Latencia inevitable.

IA Local

Ejecutas el modelo en tu propio hardware:

- Llama, Qwen, Gemma, DeepSeek, GPT-OSS y otros conviven perfectamente en local.

- Puedes cargarlos con Ollama, LM Studio u otro servidor local.

- Nada sale de tu PC salvo que tú quieras.

Ventajas:

- Privacidad real.

- Respuesta inmediata.

- Sin cuotas ni límites por uso.

Desventajas:

- Tu VRAM manda.

- Los modelos más grandes del mundo siguen fuera de tu alcance.

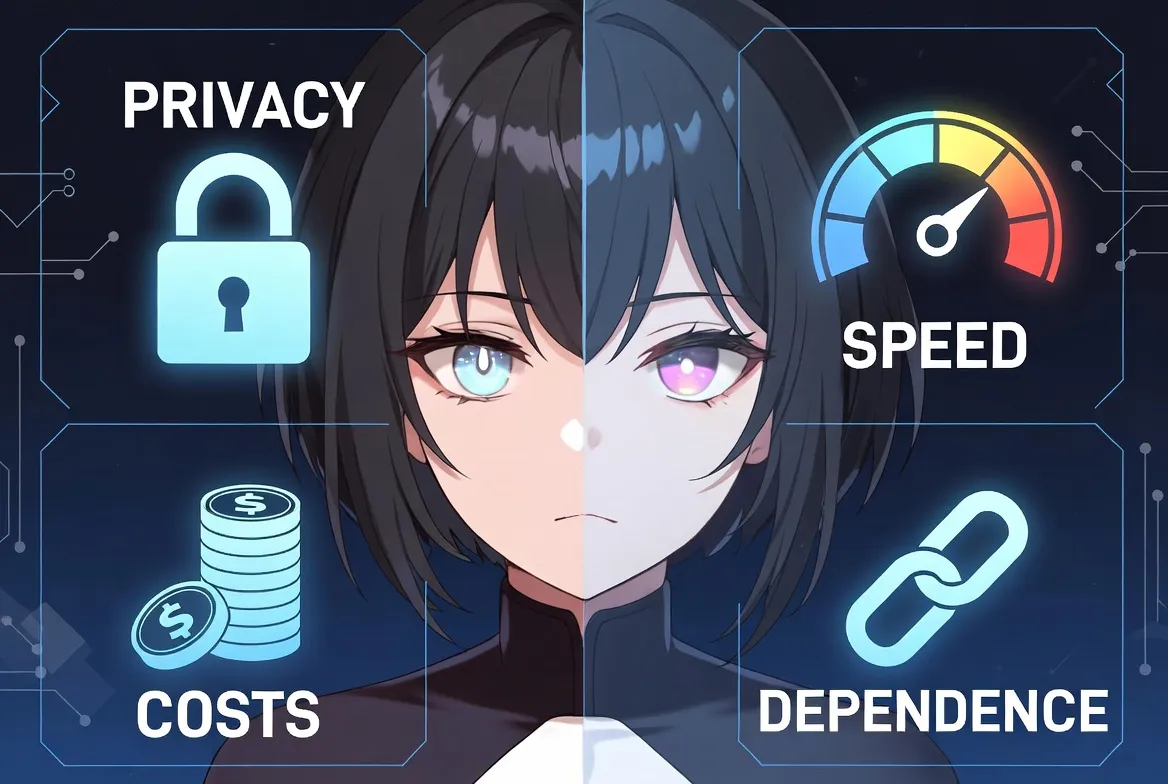

Privacidad, velocidad, costes y dependencia

Privacidad

En la nube tus datos pueden almacenarse temporalmente o verse afectados por políticas legales.

En local, tus datos no salen de tu disco.

Velocidad

- Nube: siempre hay viaje de ida y vuelta.

- Local: si el modelo cabe bien en VRAM, la respuesta es casi inmediata.

Costes

- Nube: suscripción + tokens.

- Local: hardware una vez y listo.

Dependencia

- Nube: si cambian términos o precios, te aguantas.

- Local: tú estableces las reglas.

IA local sin GPU: posible, pero muy limitada

Funciona, sí… pero solo para:

- Chat básico

- Explicaciones sencillas

- Pequeña asistencia de código

Para documentos largos, reasoning serio, programación compleja, imagen moderna o vídeo generativo, necesitas GPU.

Así que vamos con lo importante.

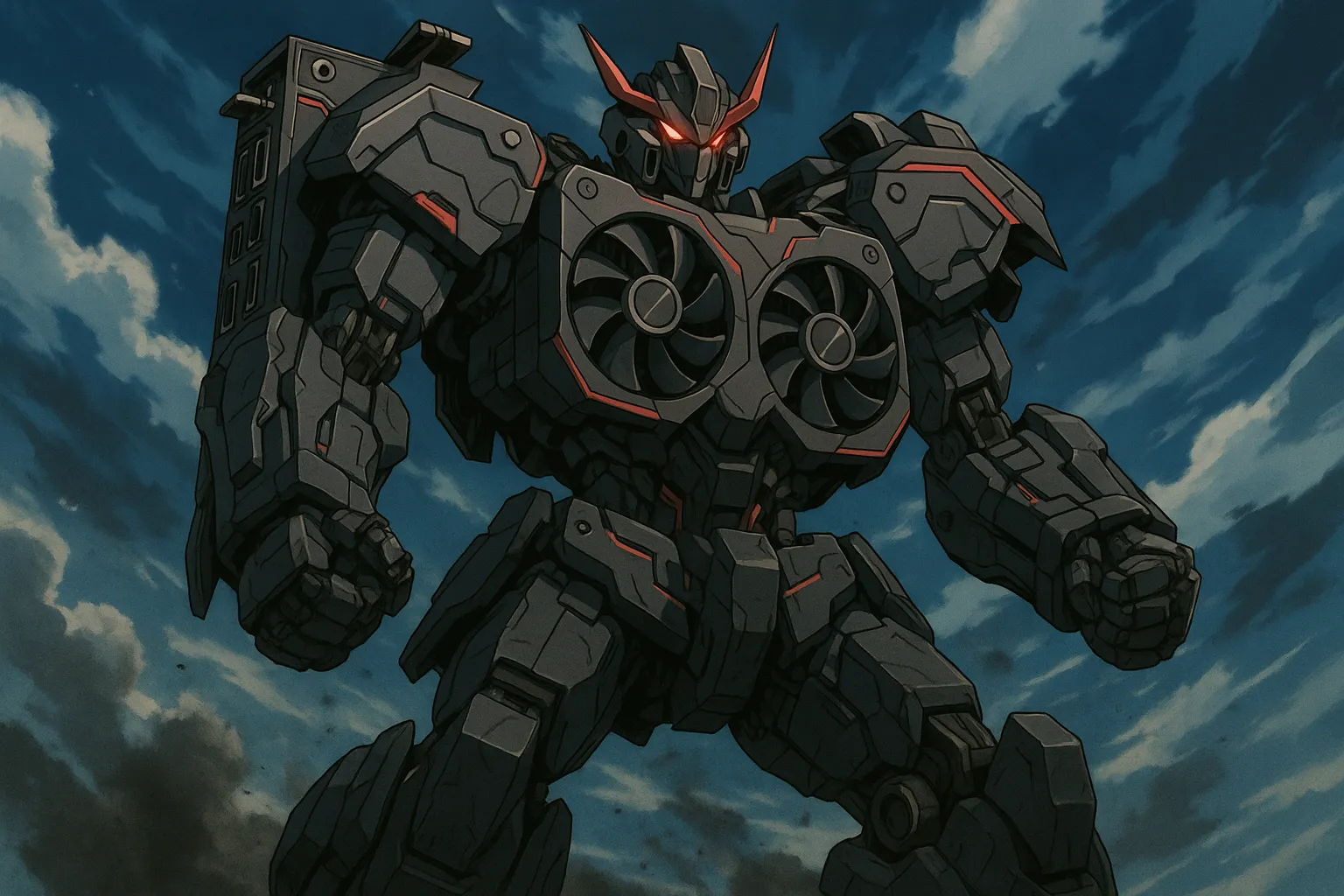

Qué puedes correr según tu GPU

Dividido en tres ligas:

- 8 GB de VRAM (gama veterana)

- 12 GB de VRAM (gama actual estable)

- 24 GB o más (4090, 5090, estaciones serias)

1) GPUs de 8 GB (RTX 2060 / 2070 / 2080 / 2080 Super / 3060 8GB…)

PC con unos años, pero aún muy capaz.

Texto: modelos perfectamente utilizables

Con 8 GB, usando cuantización adecuada, funcionan muy bien:

- Llama (últimas generaciones) de 8B

- Qwen3 pequeños y medianos

- Gemma 2 versiones compactas

- DeepSeek V3 pequeños

Modelos grandes como los de 20B sí, pueden funcionar:

- En GPUs tipo 2080 Super, un modelo open-weight de ~20B (ej.: variantes 20B de Qwen, GPT-OSS, etc.) va sorprendentemente bien en 4-bit.

- Se reparte algo de carga entre VRAM y RAM sin matar rendimiento.

- Permite programación avanzada, razonamiento medio y documentos largos.

Esto sitúa a las GPUs de 8 GB “de gama alta” (2080 Super, por ejemplo) en un punto bastante dulce para IA local funcional.

Imagen en 8 GB

- Stable Diffusion 1.5 → va perfecto.

- SDXL → usable con optimizaciones.

- FLUX ligero → viable.

Vídeo en 8 GB

Limitado a:

- Interpolación

- Upscaling

- Clips muy cortos experimentales

No es comparable por mucho al vídeo generativo avanzado de la nube.

2) GPUs de 12 GB (RTX 3060 12GB, 4070, 4070 Super…)

Este es el rango más equilibrado para la IA local moderna.

Texto: modelos muy superiores

Con 12 GB puedes mover:

- Llama 8B–13B sin despeinarte.

- Qwen3 medianos, excelentes para código.

- Gemma 2 de tamaños medios, muy equilibrados.

- Variantes recortadas de modelos grandes (DeepSeek, Mixtral, etc.) en cuantizaciones optimizadas.

- Modelos de ~20B open-weight con fluidez real, sin sufrir ni latencias raras.

Esto ya te permite:

- Programación seria

- RAG potente

- Agentes locales

- Redacción larga de alta calidad

Imagen en 12 GB

- SDXL fluido

- FLUX estándar

- Varias ControlNet a la vez

- Proyectos creativos profesionales sin nube

Vídeo en 12 GB

Puedes hacer:

- Clips de 1–2 segundos coherentes

- Motion LoRA

- Loops creativos

Aun así, lejos de la calidad de sistemas de vídeo avanzados de la nube.

3) GPUs de 24 GB o más (RTX 4090, RTX 5090…)

Aquí la IA local empieza a desplegar músculo serio.

Texto: modelos grandes y setups avanzados

Con 24 GB+ puedes:

- Ejecutar Llama 70B en cuantización alta calidad

- Servir modelos open-weight de 20B sin esfuerzo

- Experimentar con modelos open-weight de 100B+ en setups multi-GPU o particionados

- Usar Qwen, DeepSeek, Gemma 2 en sus configuraciones grandes

Esto ya cubre:

- Programación de muy alto nivel

- Razonamiento sólido

- RAG empresarial

- Agentes complejos totalmente offline

No alcanzas a GPT-5.1, pero la autonomía es brutal.

Imagen con 24–32 GB

Aquí vuelas:

- SDXL y FLUX en máxima calidad

- Entrenamiento de LoRAs pesadas

- Pipelines complejos: pose, depth, segmentación, sketch, semántica

- Iteración muy rápida, calidad profesional

Vídeo con 24–32 GB

Lo que SÍ puedes:

- Clips de 2–4 s con coherencia

- Animaciones experimentales muy interesantes

- Proyectos cortos para redes y contenido

Lo que NO puedes aún:

- Vídeo largo

- Movimientos complejos coherentes

- Calidad de sistemas tipo Grok-Video

La nube sigue por delante en vídeo de vanguardia.

IA local vs IA en la nube: ¿cuándo elegir cada una?

Gana la IA Local

- Cuando la privacidad importa de verdad

- Cuando manejas documentos internos o sensibles

- Cuando necesitas independencia y continuidad

- Cuando quieres automatizar tareas sin cuotas

- Cuando buscas latencia mínima en tu flujo de trabajo

- Cuando no quieres depender del humor de una empresa enorme

Gana la Nube

- Reasoning extremo

- Contexto enorme

- Herramientas integradas

- Visión + audio + browsing + análisis web

- Vídeo generativo avanzado

- Proyectos que requieren modelos titánicos

Tabla comparativa final

| Factor | IA Local | IA en la Nube |

|---|---|---|

| Privacidad | Máxima | Limitada |

| Velocidad | Instantánea si cabe en VRAM | Depende de red |

| Coste | Casi cero tras comprar hardware | Tokens / suscripción |

| Modelos | 7B–70B (más según setup) | Modelos gigantes como GPT-5.1 |

| Imagen | SDXL, FLUX, LoRAs locales | Modelos cerrados avanzados |

| Vídeo | Clips cortos | Sistemas avanzados tipo Grok-Video |

| Control | Total | Nulo |

Cómo empezar según tu GPU

8 GB

- Texto: Llama 8B, Qwen 7B, modelos 20B open-weight en GPUs potentes como 2080 Super

- Imagen: SD1.5 / SDXL ajustado

- Vídeo: básico

12 GB

- Texto: 8B–13B, Qwen medianos, modelos 20B fluidos

- Imagen: SDXL fluido, FLUX

- Vídeo: 1–2 s

24 GB+

- Texto: 70B y configuraciones grandes

- Imagen: FLUX y SDXL al máximo

- Vídeo: 2–4 s

No es IA vs IA… es Control vs Dependencia

La nube es potencia bruta.

La IA local es poder personal.

Lo inteligente hoy es:

- Usar nube solo cuando de verdad necesitas el músculo extremo,

- Y usar local para todo lo que importa a nivel de privacidad, continuidad y autonomía.

Si quieres seguir bajando por este agujero tienes mas artículos relacionados en TechLab y Tutoriales:

Guía Tutorial de Instalación y uso de LM Studio para modelos de lenguaje locales

Guia – Tutorial Instalación de Flux con Pinokio

Cómo usé una IA para crear una IA que creó un software espía con IA